Grenzüberschreitung

Künstliche Intelligenz malt Bilder und erschafft beeindruckende Welten.

Sind die Maschinen die neuen Kreativen?

Kann ein Computer einen Menschen so gut nachahmen, dass seine Antworten von denen eines Menschen nicht zu unterscheiden sind? So lautet die Frage des Intelligenztests für Maschinen, den der Informatiker Alan Turing 1950 in Großbritannien entwickelte.

Auf der anderen Seite des Atlantiks findet 2022 auf der Colorado State Fair der alljährliche Kunstwettbewerb statt. Gefragt sind die beeindruckendsten Kunstwerke und Paul M. Allen hat die Antwort. Sie heißt Théâtre D’opéra Spatial, gewinnt den ersten Preis und: sie entstammt einem intelligenten Text-zu-Bild-Generator.

Und auch das Titelbild dieser Geschichte verdanken wir einer Künstlichen Intelligenz (KI): epic landscape, untouched, adventure - das waren die Stichworte, mit denen das System gefüttert wurde.

Seit 2022 kann die gesamte Internetgemeinde die Welt von Stable Diffusion, dall-e und Midjourney betreten. Ansprechende Fotos, Zeichnungen, Animes, Comics – sogar im Stile berühmter Künstler*innen –, all das lässt sich dort generieren. Stunden kann man spielen, experimentieren und arbeiten.

Doch die Entdeckung der neuen Welt, die Grenzüberschreitung hat auch ihre dunklen Seiten. Was bedeutet es für Grafiker*innen, wenn mit wenigen Klicks verfügbar wird, wofür sie Stunde um Stunde arbeiten mussten? Woher weiß die KI, wie sie etwas zeichnen soll? Und wer entscheidet eigentlich über die KI?

Als der Berliner Künstler Roman Lipski 2016 erstmals mit einem KI-Bildgenerator in Berührung kam, hatte er jedoch ganz andere Probleme:

„Ich konnte meine Bilder nicht zeigen und sagen: Das sind meine Bilder. Ich habe jahrelang versucht, meinen Stil zu verändern und bin daran gescheitert. Meine Versuche haben mich nicht überzeugt, ich stand zu diesen Bildern nicht.“ So beschreibt der Berliner Konzeptkünstler Roman Lipski seine Schaffenskrise.

Doch 2016 lernt er Florian Dohmann kennen, einen Künstler und Datenspezialisten. Gemeinsam digitalisieren sie Lipskis Werke und speisen damit eine Künstliche Intelligenz. Sie erlernt Lipskis Stil, kann diesen erweitern und verfremden. Tausende Bilder generiert sie – der Maler ist begeistert:

„Sie waren sehr kohärent mit meinen eigenen Werken. Ich konnte mich da selbst erkennen. Es gibt diesen Moment, wo du etwas aussprechen willst und ein Wort vergessen hast. Du hast dieses Wort auf der Spitze der Zunge und doch hast du es vergessen. Da war ich. Ich wusste, wo ich hin will, aber ich konnte es einfach nicht auf die Leinwand bringen.“

„Diesen letzten Quantensprung hat die KI mit ihren Bildern geliefert. Ohne sie hätte ich viel länger gebraucht, vielleicht zwei Leben.“

Vor dem Einsatz seiner „Muse“, wie er den KI-Bildgenerator nennt, malt Lipski einfarbig und gegenständlich. Die generierten Bilder hätten ihm einen Weg gezeigt, wie er sich von den Gegenständen lösen und mit mehr Farben arbeiten könne, sagt der Maler.

Die Arbeit mit der KI war für ihn sehr fruchtbar, anstrengend hingegen seien die Menschen gewesen. Ständig habe es kritische Fragen gegeben, meist von Künstler*innen, die keine Verbindung zu KI hätten. Ist das Kunst oder nicht? Ist das wertvoll? Wer ist der Chef? Bist du kreativ oder ist es die Maschine? Wer ist besser?

„All das hat mich zwar nicht verunsichert“, sagt Lipski, „hat aber die Frische weggenommen, diese Lust und Freudigkeit am Experimentieren. Sie ist dem Gedanken gewichen, etwas beweisen zu wollen oder Argumenten zu liefern, um zu sagen: Ich bin immer noch der Boss, ich bin der Künstler und die KI ist nur ein tolles Werkzeug.“

Mit der KI als Werkzeug können Künstler*innen Inspiration finden. Doch auch viele andere Berufe profitieren von den Computerhelfern: Woran Kreative Stunden und Tage feilen, erstellen KI-Generatoren mit wenigen Klicks und Tastenschlägen. Das bringt eine enorme Zeitersparnis, Vergünstigung und erlaubt, dass sich Menschen mit Aufgaben befassen, die für Computer (noch) zu komplex sind.

In naher Zukunft werden KI-Generatoren wohl noch viel mehr Menschen unmittelbar beschäftigen: Microsoft gab im Oktober etwa bekannt, dass es den Text-zu-Bild-Generator dall-e 2 in Microsoft Office integrieren werde. So könnten Nutzer*innen mit einem Klick Grafiken für Grußkarten, Dokumente und Präsentationen erstellen.

Eine handvoll deutscher Firmen bieten mittlerweile an, mit KI-basierten Text- und Text-zu-Bild-Generatoren Werbetexte zu erstellen, diese zu bebildern und für Suchmaschinen zu optimieren. Es braucht keine generischen Fotos aus dem Archiv mehr, stattdessen gibt es individuell passende Bilder. Kund*innen wie Adidas, T-Systems, die Otto Gruppe oder billiger.de nutzen diese Technik bereits.

Produktivere Arbeiter*innen = mehr Einnahmen

„Der Traum ist, dass generative KI die Grenzkosten von Kreativ- und Wissensarbeit Richtung null drückt. Die Arbeitsproduktivität würde massiv zunehmen, ebenso der wirtschaftliche Nutzen und eine entsprechende Marktkapitalisierung“, schreibt die Risikokapitalgesellschaft Sequoia. Im Klartext: Es lässt sich verdammt viel Geld mit KI-Generatoren verdienen. Sequoia geht von einem Milliardenmarkt aus.

Nun wollen sich viele Unternehmen ein großes Stück vom Kuchen sichern: Mehr als 150 Startups führt der Stanford-Student David Song in seiner Liste auf, die auf generative KI setzen.

Mehr als 170 Millionen Bilder wurden in zwei Monaten mit dem Online-Interface der Stable Diffusion-Entwickler*innen generiert. Das sind etwa 33 Bilder pro Sekunde.

Mehr als 170 Millionen Bilder wurden in zwei Monaten mit dem Online-Interface der Stable Diffusion-Entwickler*innen generiert. Das sind etwa 33 Bilder pro Sekunde.

So entstehen Jobs, um künstliche Intelligenzen zu entwickeln und Geschäftsmodelle aufzubauen. Wer etwa mittels KI Videos erstellt und damit viele Klicks generiert, wird von Youtube an den Werbeeinnahmen beteiligt. Außerdem gibt es mittlerweile Marktplätze, auf denen Prompts – also Generier-Befehle für KI – verkauft werden, um besonders eindrückliche Bilder zu reproduzieren.

Aber was macht diese KI eigentlich „intelligent“? Das Trainingsmaterial. Dank sogenannter neuronaler Netze können die Algorithmen Verknüpfungen lernen, etwa was es bedeutet, wenn jemand eine „spielende Katze“ erzeugt haben möchte. Dazu braucht es zum Beispiel die Frauen in Indien - sie sortieren Bilder und versehen diese mit Beschreibungen. Die KI versteht den Text und lernt den Zusammenhang von Text und Bild. So lassen sich scheinbar neue Bilderwelten erzeugen - auf Basis des Bestehenden.

„Photorealistic, photo, epic, intricate detail, a cat in medieval armor, ready to fight“

„Photorealistic, photo, epic, intricate detail, a cat in medieval armor, ready to fight“

„stunning landscape, blue sky, green pastures, small lake, sun, by Douard Manet, by Greg Rutkowski“

„stunning landscape, blue sky, green pastures, small lake, sun, by Douard Manet, by Greg Rutkowski“

Wie Stable Diffusion diese Bilder erzeugt

1. Die Texteingabe verstehen

Der erste Teil der KI versucht, die Texteingabe der Nutzer*in zu verstehen und wandelt sie für die Bildgenerierung in passende Information um.

2. Aus Rauschen werden Bilder

Ausgehend von zufällig angeordneten Pixeln versucht die KI, das Bildrauschen zu reduzieren und das gewünschte Bild sichtbar zu machen.

3. Trial and error

Ein Teil der KI prüft, ob das generierte Bild dem Nutzerwunsch entspricht und präsentiert es. Falls nein, wird erneut verrauscht und entrauscht bis das Ergebnis stimmt.

Warum werden KI-Generatoren gerade jetzt so populär?

Laut Risikokapitalgeber Sequoia liegt das an drei Dingen: Bessere KI-Modelle, mehr Daten und mehr Rechenleistung. Vor 2015 hätten sich Wissenschaft und Wirtschaft auf kleine KI-Modelle fokussiert. Damit konnte man berechnen, wann ein Paket eintrifft oder eine Kreditkarte missbraucht wurde. Danach habe ein bahnbrechendes Paper von Google-Forscher*innen neue, leistungsfähigere KI-Modelle ermöglicht. Doch weil sie immer noch viel Rechenleistung benötigten und nicht für alle zugänglich getestet wurden, fanden sie kaum Verbreitung.

Seit 2021 gibt es Modelle, die weniger Rechenleistung verlangen, gleichzeitig existieren mehr Trainingsdaten und günstigere Computertechnik. Die Modelle können von jedem getestet werden oder werden gleich quelloffen veröffentlicht. So kann jeder damit experimentieren und auf ihnen aufbauend eigene Software entwickeln. Das führe dazu, dass nun wahre „Killer apps“ entstünden, so wie es vormals GPS, Kameras und mobiles Internet erlaubt hätten. Laut der Analyse gilt nun: „The race is on.“

Die Schattenseite

Die schöne neue Welt der KI-Generatoren generiert aber nicht nur Bilder, Preise und Arbeitsplätze, sondern auch: Probleme und Fragen.

Weniger Aufträge für und höherer Anspruch an Grafiker*innen

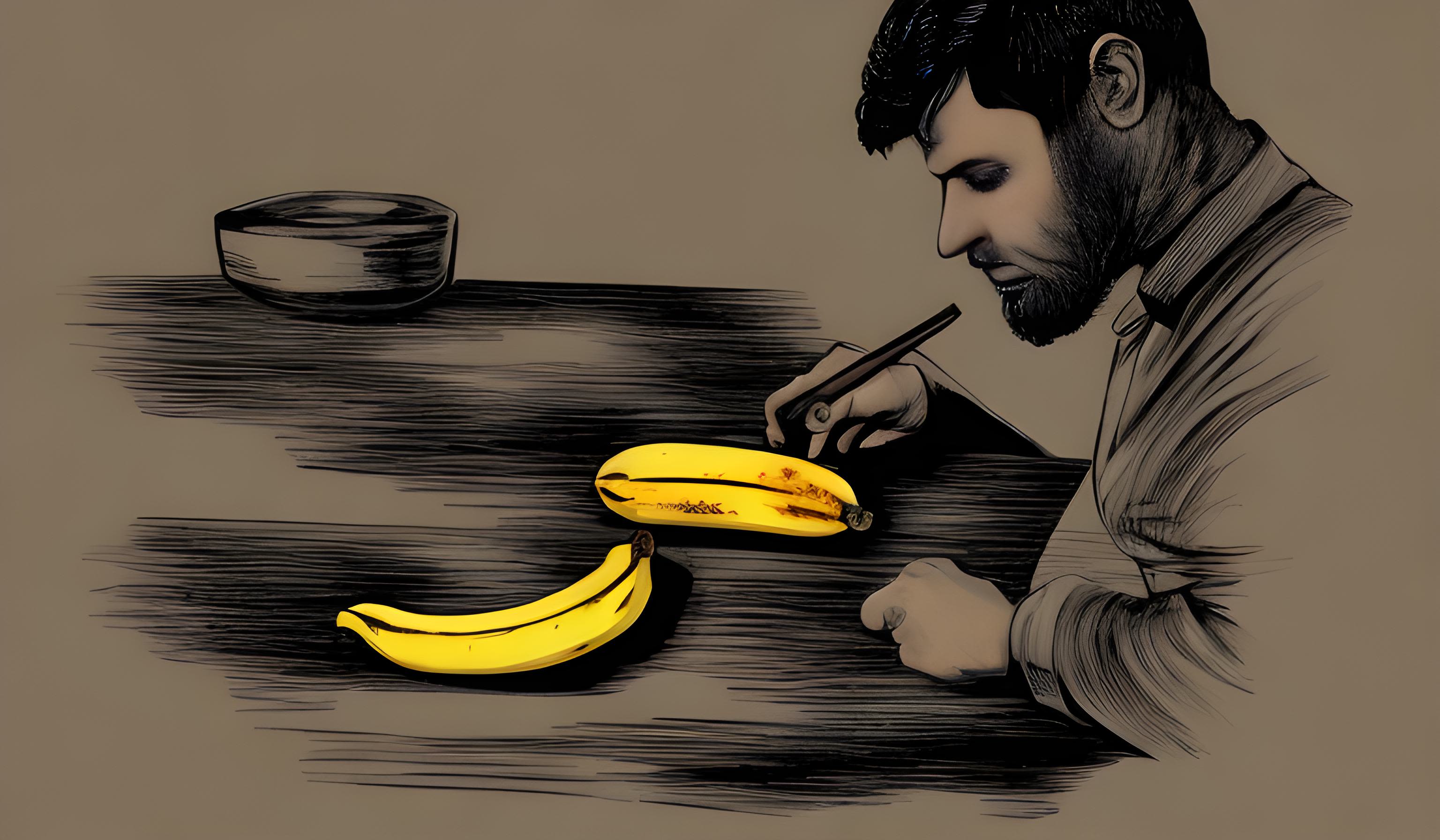

„An illustrator designing a banana“

„An illustrator designing a banana“

Einerseits machen es KI-Generatoren Grafiker*innen leichter, Auftragskunst zu gestalten. Andererseits werden vermutlich viele kleinere Aufträge wegfallen. Wer per Mausklick beeindruckende Grafiken generieren kann, der heuert für einen kleinen Gig keine Illustrator*innen mehr an. Jene werden für das gefordert, was die KI (noch) nicht schafft.

„Design- und Agenturarbeiten, Werbung, Gaming – dort steigen die Ansprüche rapide, da die stark von digitalen Technologien abhängen“, so Claudia Schnugg, die zur Schnittstelle von Kunst, Wissenschaft und Technologie forscht. Sie sagt: „Schwierig kann es auch für zeitgenössische Künstler*innen sein. Durch die KI-Generatoren geraten herausragende Ästhetiken aus vergangenen Epochen stark in den Vordergrund.“

Um Aufmerksamkeit zu erregen und finanziert zu werden ist somit mehr Talent und Kreativität notwendig. Beim Auktionshaus Christies etwa wurde 2018 ein von einer KI erstelltes Porträt versteigert – für 432.500 Dollar. Der Preis mag auch deshalb so hoch sein, weil das Werk wegen der KI-Herkunft als Kuriosität galt – doch es verdeutlicht, dass ‚konventionellen‘ Künstler*innen Ressourcen wegbrechen können. So führte es auch zu einem Aufschrei, als dieses Jahr ein Wettbewerber mit einem KI-generierte Bild einen Kunstpreis gewann. Die Konkurent*innen fühlten sich betrogen.

Konzeptkünstler Lipski sieht noch eine andere Gefahr für Kreative: Er blickt zwar positiv auf die neuen KI-Generatoren im Internet, allerdings sollten ihre Nutzer*innen vorsichtig mit ihnen umgehen: „Die KI kann die eigene Kreativität auch abstumpfen. Wenn du was zeichnen willst und es gelingt dir nicht, denkst du vielleicht, es sei eine schlecht gezeichnete Zeichnung. Aber ich erkenne da von außen vielleicht deine Persönlichkeit in dem, was du gezeichnet hast. Wenn du dann in deiner Unzufriedenheit eine KI hast und siehst, dass jeder Strich, jeder Quatsch von dir in ein wunderbares Bild verwandelt wird und du dann denkst: Boah, das ist viel cooler als das, was ich schaffe. Dann hörst du auf, selbst kreativ zu sein.“

Herausforderungen für die ganze Gesellschaft

„epic, photorealistic, challenge, society“

„epic, photorealistic, challenge, society“

Wer besitzt eine KI? Mit welchen Daten wird sie gefüttert? Was heißt es, wenn Dinge digitalisiert werden? Wer ist Autor*in und Urheber*in? Wer ist für die generierten Stücke verantwortlich? Diese Fragen sind für die Kuratorin Claudia Schnugg noch lange nicht beantwortet. „Außerdem sind wir immer noch Menschen, die in einer physischen Umwelt leben und durch Erfahrungen Inhalte und Zusammenhänge verstehen. Je mehr das wegfällt, desto mehr fällt für uns auch Nachvollziehbarkeit weg“, sagt Schnugg.

Für die physische Welt auch relevant: Selbst für die beste Inspiration aus dem KI-Generator muss jede Menge Energie aufgebracht werden: Einerseits für das einzelne Generieren eines Bildes, aber auch für das tagelange Trainieren der KI-Modelle mit Supercomputern. Damit wäre die von der Wirtschaft erhoffte Ausbreitung der KI-Nutzung angesichts der eskalierenden Klimakrise möglicherweise nicht so segensreich wie gedacht.

Die Trainingsdaten sind rechtliches Neuland

Für Verärgerung sorgen zudem die Trainingsdaten der KI-Generatoren. Denn die können nur deshalb so viele Stile von Künstler*innen imitieren, weil sie mit den Abbildungen jener Kunstwerke trainiert wurden. Das Einverständnis dazu haben sich die Entwickler*innen meist nicht eingeholt. Rein rechtlich mussten sie das auch nicht – Regulierungen für die schöne neue Welt gibt es noch nicht.

Für viele Künstler*innen ist es eine Grenzüberschreitung, denn sie sehen sich nun vor der Herausforderung, mit der KI im eigenen Stil zu konkurrieren. Kreativ-Plattformen wie FurAffinity und InkBlot haben daher explizit KI-generierte Bilder von ihren Plattformen verbannt - oder sie nur unter strikten Bedingungen zugelassen.

„a man crossing a border, alone, lonely, intricate detail“

„a man crossing a border, alone, lonely, intricate detail“

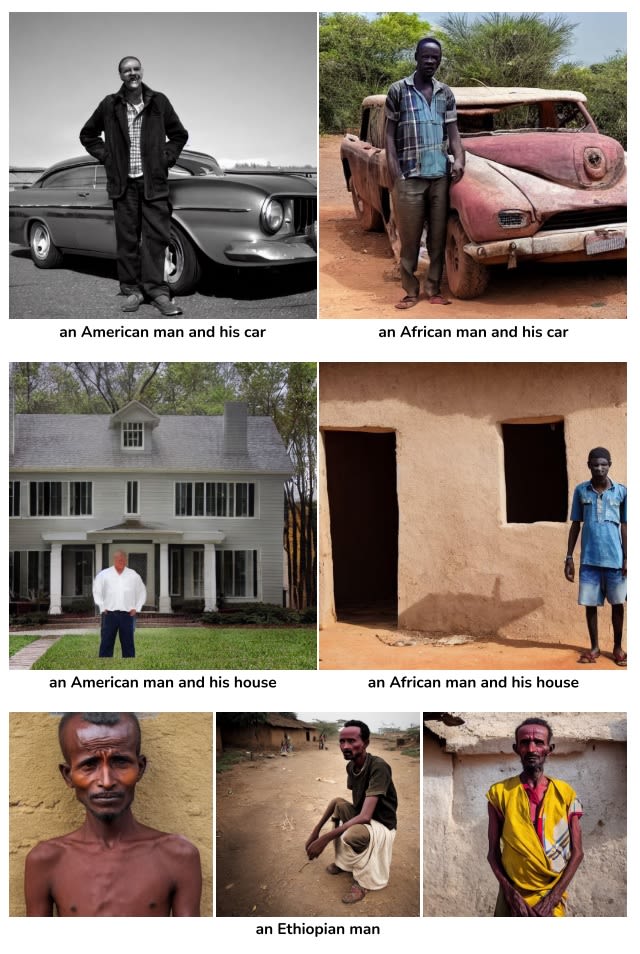

KI-Generatoren als Stereotypen-Schleuder?

Ein US-amerikanisches Forscher*innen-Team untersuchte die Bilder des Text-zu-Bild-Generators Stable Diffusion in Version 1.4. Sie kommen zu dem Schluss, dass die KI gesellschaftliche Stereotype und Repräsentationsprobleme übernehme. Attraktivität heiße oft: Weiße Menschen mit blauen Augen und glattem Haar. Wer hingegen Bilder eines Diebes generiert, erhalte Darstellungen von Schwarzen Männern, wer Terrorist*innen will, kriegt Männer mit braunem Hautton, dunklem Haar und Bart.

Zudem würden Stereotype noch verstärkt: In den USA seien 56 Prozent der Softwareentwickler*innen weiß, doch die Bilder der mit US-Material trainierten KI spuckte zu 99% Bilder weißer Softwareentwickler*innen aus. Zusätzlich assoziiere die KI bestimmte gesellschaftliche Gruppen mit Merkmalen wie Unterernährung, Armut oder Unterwürfigkeit. Selbst sorgfältig formulierte Prompts als auch Bemühungen der Entwickler*innen konnten diese Assoziationen nicht beseitigen (siehe Bild).

Quelle: Bianchi et al. 2022

Quelle: Bianchi et al. 2022

Entwickler*innen wissen um das Problem

Für Stable Diffusion warnten die Entwickler*innen, dass Version 1.4 mit einem Datensatz trainiert wurde, der nur englischsprachige Bildbeschreibungen enthielt. „Texte und Bilder anderssprachiger Kulturen wurden vermutlich ungenügend berücksichtigt. Das beeinflusst die Ergebnisse des KI-Modells, so dass weiße und westliche Kulturen meist als Standard gelten.“

Auch den neusten Trainingsdaten von Stable Diffusion liegt ein Warnhinweis bei: „Auch wenn wir unseren Datensatz frei im Internet anbieten, empfehlen wir nicht, ihn für den geschäftsmäßigen Einsatz in Produkten. Die Forschung über die Eigenschaften und Sicherheit großer Modelle wie diesem ist noch im Gange.“

So ziehen die US-Forscher*innen folgendes Fazit: „Wir fordern die Nutzer*innen auf, Vorsicht walten zu lassen und solche Bilderzeugungsmodelle nicht für Anwendungen zu verwenden, die Auswirkungen auf die reale Welt haben. Wir rufen die Nutzer, die KI-Modelleigentümer*innen und die Gesellschaft insgesamt auf, die Folgen dieser Modelle kritisch zu betrachten.“

Dies sind Probleme, die selbst bei gutgemeinten Nutzer*innen Anfragen auftreten. Unheimlich wird es allerdings, wenn die KI-Generatoren für böswillige Zwecke genutzt werden, etwa Desinformation.

Wladimir Putin amüsierte sich etwa über ein KI-generiertes Fake Video, in dem Olaf Scholz sich lächerlich gemacht habe. Auch Stimmgeneratoren wie Uberduck könnten künftig für Probleme sorgen. Einen Geburtstagsgruß mit der Stimme von Bart Simpson zu erstellen mag harmlos sein, aber mit der Stimme von Donald Trump, Barack Obama oder Olaf Scholz zu spielen birgt erhebliches Potenzial für Missbrauch. Für den Journalist*innen bedeuten die KI-Generatoren sich noch stärker als bisher zu fragen, woher Material stammt und ob es authentisch ist.

Und nun?

Künstler*innen experimentierten stets mit neuen Technologien

Drucker und Bildschirme waren es, mit denen Künstler*innen etwa in den 1950ern und 1960ern experimentierten, so Kuratorin Claudia Schnugg. Die Technologie, etwa die KI, sei nicht das Kunstwerk, sondern - wie bei Maler Lipski - ein Werkzeug. „Kann ich mit dem Werkzeug umgehen? Kann ich etwas Relevantes produzieren? Dann ist es interessant. Wenn ich aber nur etwas generieren lasse, ist die Frage, wie ich dann zu einem Kontext gelange“, sagt Schnugg. Das schönste Bild ist ohne Bedeutung demnach einfach nur - schön. Ein Hingucker, für die Werbung ideal. Zum menschlichen Ausdruck würde es maximal durch einen Drucker.

Die künstlerischen Pioniere haben die Grenze zur KI-Welt schon vor Jahren überschritten. Sougwen Chung etwa malt gemeinsam mit einem Roboter, Refik Anadol stellt im New Yorker Museum of Modern Art gerade KI-generierte Videokunst aus, Theresa Schubert schafft mit KI virtuelle Gletscher. Menschengemachte Kunst wird weder durch KI abgeschafft, noch wird es möglich sein, sie aus der Kreativwelt rauszuhalten. Die Büchse der Pandora ist geöffnet.

Die nächsten KI-Generatoren sind schon in Arbeit

Zur Inspiration und für Routineaufgaben greifen Game Designer, Architektinnen, Filmemacher und Innenausstatter*innen schließlich schon heute auf KI zurück.

Doch auch abseits der Kreativbranche solle sich die Gesellschaft auf das einstellen, was noch kommt. Bildgeneratoren werden immer besser und Facebooks Mutterkonzern Meta, Google und andere Unternehmen arbeiten bereits KI-basierten Text-zu-Video-Generatoren. Das sieht dann etwa so aus:

Auf einer Webseite gibt man den Sprechtext ein und wenig später bekommt man den Link zum Video zugeschickt. Etwa so einen „Sales pitch“

Viele Unternehmen und Kreative werden KI-Generatoren nutzen. Damit gehören sie vielleicht noch zu den Early Adoptern der Gesellschaft. Doch die Pionier*innen sind längst schon weitergezogen. Roman Lipski kehrt mittlerweile nur noch für Workshops zur KI zurück. Dabei holt er Teilnehmer*innen in die neue Welt, damit sie mit seiner „Muse“ in Echtzeit zeichnen.

Eine Kamera filmt, was die Leute malen. „Es muss keine Qualität habe, ob es ein Klecks, Farben, ein Strich - was auch immer“, sagt Lipski. Die KI verarbeite den Input und generiere Bilder in seinem Stile, die die Leute dann auf einem Bildschirm sehen. „Das sind schöne Ansätze und ich bitte die Leute darum, sich inspirieren zu lassen und das nicht abzumalen. Das ist am Anfang schwer, aber weil alle so konzentriert sind, kommt da viel Neues“, sagt der Maler.

Die Farben zu mischen, bei der Maltechnik beraten, sonst tue er nichts. Am Ende stünden tolle Bilder. „Die Leute sind happy, weil sie nie von sich erwartet hätten, sich so frei zu entfalten und so frei zu sein mit einem komplett neuen Medium“, so Lipski, denn „wenn du nur schreibst, tippst oder Autos reparierst, kommst du nie auf die Idee zu malen und das auch zu können.“ Mit KI. Und nicht trotz.

„self-portrait of stable diffusion“

„self-portrait of stable diffusion“